La Comisión Europea se pronunció al respecto en la Propuesta de Reglamento sobre inteligencia artificial, que señala el alto riesgo del uso de la creación de perfiles a partir del reconocimiento facial y sugiere que los integrantes de la Unión Europea prohíban prácticas que atenten contra los derechos fundamentales de los ciudadanos, como la vigilancia en tiempo real que recoja datos biométricos.

Censura, sesgos y detenciones: los errores de la inteligencia artificial al analizar fotos y vídeos y generar perfiles y contenido

Lo usual es que el discurso público alrededor de la incorporación de la inteligencia artificial se ubique en espectros opuestos: el «tecno-optimismo» que asume que esta tecnología será clave en una mejora exponencial e inminente en nuestro futuro próximo y los pesimistas cuyas proyecciones se aproximan más a las distopías que ilustran un control total de la ciudadanía o incluso la amenaza de robots rebeldes.

A pesar de las diferencias de enfoque, ambas propuestas parten del supuesto de que la inteligencia artificial funcionará perfectamente y de una forma que supere el razonamiento humano. La realidad ha demostrado que estos sistemas están llenos de errores muy parecidos a los que cometemos todos los días, reflejando el contexto cultural de quienes los programan.

Seguridad

La primera persona arrestada erróneamente tras ser identificado por un algoritmo de reconocimiento facial se llama Robert Julian-Borchak Williams. Fue detenido el pasado enero en Detroit, EEUU, delante de su mujer e hijos, después de que el software DataWorks Plus de la policía de Michigan lo identificara como la persona que robó cinco relojes en una tienda.

Williams estuvo detenido toda la noche antes de que la policía admitiera que la coincidencia entre la licencia de conducir del arrestado (que no sabía que este documento se encontraba en la base de datos del sistema) y las imágenes del delito, captadas por una cámara de vigilancia, eran erróneas.

Desde entonces han surgido varios casos más en los que hombres negros han sido acusados y detenidos por crímenes que no pudieron haber cometido, revelando un sesgo imprevisto en la programación de la tecnología de reconocimiento facial usada por los departamentos de seguridad estadounidenses.

Varios investigadores y activistas, como los integrantes del proyecto Gender Shades, han denunciado este defecto en estos sistemas y su uso por parte de las fuerzas de seguridad. Han demostrado que esta tecnología ha mostrado grandes fracasos que podrían ser evidentes para un observador humano, pero no para la inteligencia artificial, especialmente al analizar perfiles de personas de piel oscura.

En un experimento peculiar, la Unión Americana de Libertades Civiles (ACLU por sus siglas en inglés) publicó los resultados de una prueba en el 2018 en los que el algoritmo de Amazon, Rekognition, identificó a 28 miembros del Congreso norteamericano con fotos policiales de personas condenadas o sospechosas en casos de delincuencia.

La Comisión Europea se pronunció al respecto en la Propuesta de Reglamento sobre inteligencia artificial, que señala el alto riesgo del uso de la creación de perfiles a partir del reconocimiento facial y sugiere que los integrantes de la Unión Europea prohíban prácticas que atenten contra los derechos fundamentales de los ciudadanos, como la vigilancia en tiempo real que recoja datos biométricos.

Redes sociales

Cuando se habla de los algoritmos en redes sociales, la mayoría de las personas apuntan a la curación de contenidos que busca ofrecer contenido parecido o relacionado con el que el usuario haya interactuado anteriormente, muchas veces exponiéndolo a matrices de opinión radicales. Otra cara del uso de la inteligencia artificial tiene que ver con la censura automática de material audiovisual y fotos.

La mayoría de estas medidas están tomadas para eliminar publicaciones que rompan las reglas de cada plataforma, que en la mayoría de los casos tienen que ver con mensajes de terrorismo, discursos de odio y, en algunas redes, desnudez.

La automatización de estos procesos lleva a casos sumamente curiosos. Hasta ahora se han conocido casos en los que se han eliminado fotos de buñuelos, cebollas y desiertos publicadas en Facebook por haber interpretado las imágenes como cuerpos desnudos.

El reconocimientos de imágenes no se salvan tampoco del sesgo racial. Un usuario del servicio Google Photos criticó el hecho de que el sistema etiquetó a dos de sus amigos negros como «gorilas». Su queja fue compartida cientos de veces y Google emitió una disculpa pública.

Un escándalo parecido acaeció cuando Facebook recomendaba «seguir viendo vídeos de primates» a las personas que hubieran visto uno en el que figuraban personas negras, producto de su sistema de recomendaciones por inteligencia artificial.

De manera parecida a otros ejemplos, el ‘chatbot’ programado por Microsoft y bautizado como Tay en la red social Twitter fue víctima de información viciada, esta vez intencionada y por la interacción de los usuarios.

El ‘bot’ de inteligencia artificial interactuaba con otros perfiles con respuestas inocuas hasta que empezó a repetir opiniones de usuarios que le enviaban mensajes diciendo que «los judíos causaron los eventos del 11 de septiembre» y que «las feministas deberían morir y arder en el infierno». Tay fue desactivado en menos de 24 horas desde su primera interacción.

En otro frente, varios usuarios han protestado contra la política de Instagram y Facebook que elimina los desnudos. Una instancia curiosa es la de las páginas de museos a las que se le han retirado imágenes de cuadros históricos por la aparición de pezones o vello púbico.

Por otro lado varias ‘influencers’ han protestado contra la aparente hipocresía que lleva a censurar los pezones femeninos, pero no los masculinos, llegando al punto de que una mujer con pechos lo suficientemente pequeños podía evitar la censura que sufrían compañeras más dotadas.

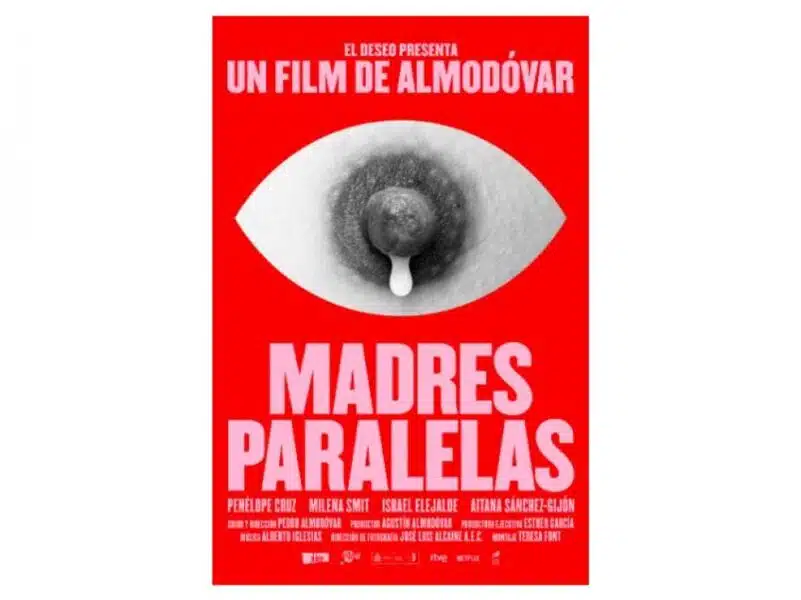

El caso del cartel de «Madres paralelas», la película de Pedro Almodóvar, ha despertado diferentes opiniones. En el material se observa un diseño que incluye un pezón femenino del que brota una gota de leche, encasillado en la forma estilizado de un ojo como para imitar una pupila y lágrima. Es uno de varios casos que han hecho surgir discusiones sobre la libertad de expresión y artística en estas plataformas.

Generación de contenido

No es solo en la detección y clasificación de imágenes donde la inteligencia artificial expone sus sesgos. Un ejemplo muy claro recuerda a la serie policíaca «CSI», en la que los personajes a menudo hacían ‘zoom’ en una imagen para mejorar su calidad. La diferencia entre el «CSI» y la vida real es que la inteligencia artificial no mejora la calidad de una imagen, sino que directamente inventa lo que presenta posteriormente.

Es lo que se observa en numerosas aplicaciones de «despixelación», especialmente cuando trabaja con rostros humanos. En la mayoría de los casos, la base de datos contiene una mayoría de personas con piel blanca, lo cual lleva a una situaciones en las que, por ejemplo, una imagen del expresidente estadounidense Barack Obama se vuelve un hombre rubio y de ojos azules.

También el contenido que supuestamente está generado completamente por inteligencia artificial sufre de ciertos problemas. Para empezar, está el problema de que no «inventan» los productos que emiten, sino que hacen amalgamas a partir de bases de datos con creaciones humanas, lo cual ya da para una discusión diferente sobre ética y derechos de autores.

Pero incluso los modelos más avanzados de generación de imágenes siguen teniendo problemas en algunos aspectos de la figura humana. En muchas ocasiones podemos observar que se forman artefactos y detalles fuera de lugar, especialmente en la anatomía de la mano y el número de dientes que presentan.

Por ahora, varias organizaciones de verificación de noticias publican guías con pistas como estas para detectar imágenes generadas artificialmente, pero nada impide que una persona retoque y refine estos detalles para que terminen pareciendo mucho más reales. Un motivo de preocupación por razones completamente distintas.

Noticias Relacionadas: